nom féminin

(de information)

adjectif

Une science très récente.

L'informatique peut être définie comme la science du traitement automatique de l'information par des ordinateurs. En effet, le terme « informatique » vient de la contraction des mots « information » et « automatique ». Il a été proposé en 1962 par Philippe Dreyfus et accepté par l'Académie française en 1966. L'informatique est véritablement née avec l'apparition des premiers ordinateurs à la fin de la Seconde Guerre mondiale, avec pour principal objectif de pallier les insuffisances humaines en matière de calcul numérique. Mais très vite, l'informatique va s'immiscer dans tous les domaines, de la recherche scientifique (physique, chimie, biologie, géologie, météorologie, médecine, etc.), l'économie (en particulier dans les systèmes bancaires), les loisirs (cinéma, jeux vidéo, etc.), jusqu'à la sphère privée (réseaux sociaux, etc.).

Historique et évolution de l'informatique.

Les bouliers sont les plus anciennes machines à calculer. L'idée de fabriquer de tels instruments facilitant le calcul est née en Chine, au cours du Ier millénaire avant J.-C.

En 1642, le philosophe et mathématicien français Blaise Pascal construit la première machine à calculer (la Pascaline, aussi appelée roue Pascal), capable d'effectuer des additions et des soustractions.

Vers 1800, un autre Français, Joseph Marie Jacquard, met au point un métier à tisser qui utilise des cartons perforés pour commander les mouvements des aiguilles. Et un peu plus tard, en 1833, l'Anglais Charles Babbage reprend ce principe pour construire une machine capable d'exécuter toutes les opérations et de stocker les résultats. Son associée, la mathématicienne Ada Byron, posera par la suite les principes de base de la programmation.

Mais c'est aux États-Unis, en 1945, que naît le premier véritable ordinateur de l'histoire : l'ENIAC (Electronic Numerator Integrator and Computer). Celui-ci pèse 30 tonnes et occupe une surface d'environ 100 m2. Il comporte 17 000 tubes à vide et, parfois, des cafards s'introduisent dans ces tubes, faussant les résultats. C'est pour cette raison que l'on parle aujourd'hui encore de « bug informatique » – ce mot provenant de l'anglais bug, qui signifie « cafard ».

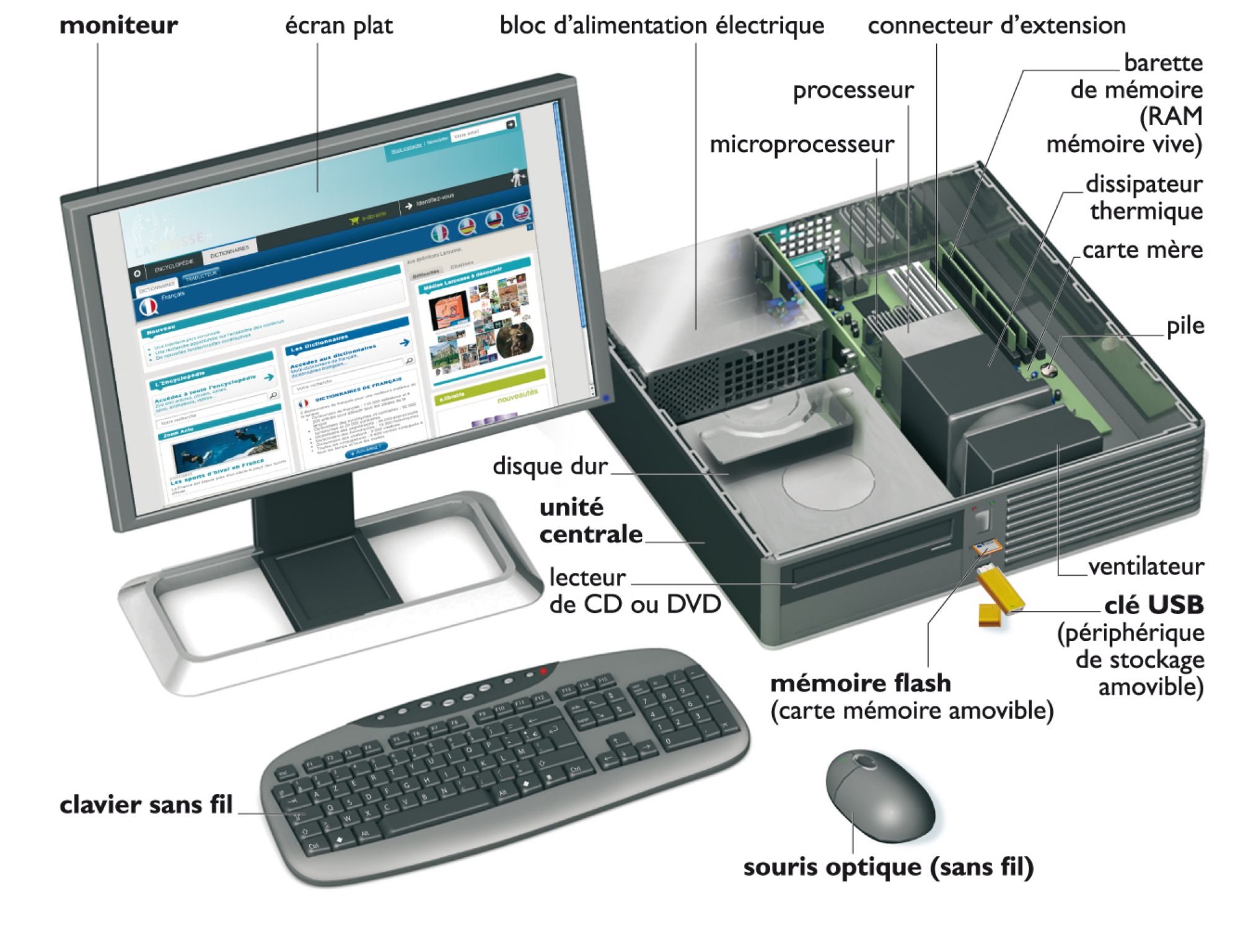

L'invention du transistor en 1948 puis celle des circuits intégrés (souvent appelés puces) en 1964 permettent la miniaturisation des composants électroniques, ouvrant ainsi la voie à la micro-informatique. En 1971, le premier microprocesseur (Intel 4004) sort des ateliers de la société américaine Intel. Il contient 2 300 transistors et exécute 60 000 instructions par seconde. En comparaison, un microprocesseur commercialisé en 2010 comprend plus d'un milliard de transistors et exécute plus de 100 milliards d'instructions par seconde.

En 1981, la société américaine IBM lance le PC (Personal Computer ou « ordinateur personnel ») et révolutionne la micro-informatique. Parallèlement, de nombreux logiciels d'application (traitement de texte, gestion de base de données, etc.) voient le jour, parmi lesquels ceux de la société Microsoft de Bill Gates, fondée en 1975.

En 1984, les systèmes Macintosh d'Apple Computer sont les premiers, sous l'égide de Steve Jobs, à être dotés d'une interface graphique : l'utilisateur peut désormais se servir d'une souris et cliquer sur des icônes au lieu de taper les commandes au clavier. La première version de Windows, commercialisée par Microsoft en 1985, s'en inspire pour rendre l'utilisation des PC plus conviviale.

Depuis, les ordinateurs suivent la fameuse loi de Moore qui stipule que le nombre de transistors par circuit de même taille double, à prix constants, tous les 18 mois. La limite physique à cette augmentation exponentielle de la puissance des ordinateurs (dimension des puces réduite à la taille d'un atome) devrait toutefois être atteinte vers 2020. Une nouvelle révolution informatique est donc à prévoir.

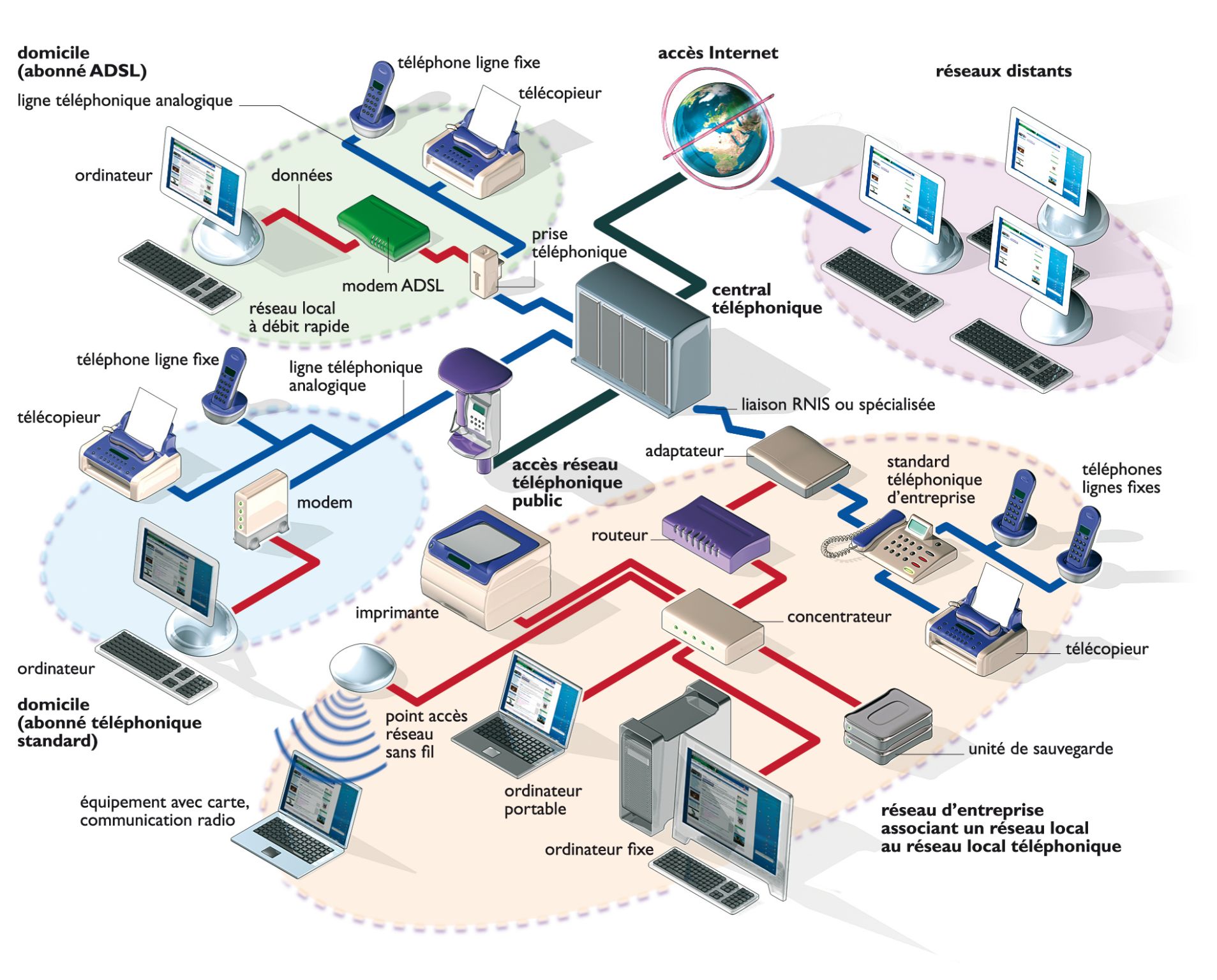

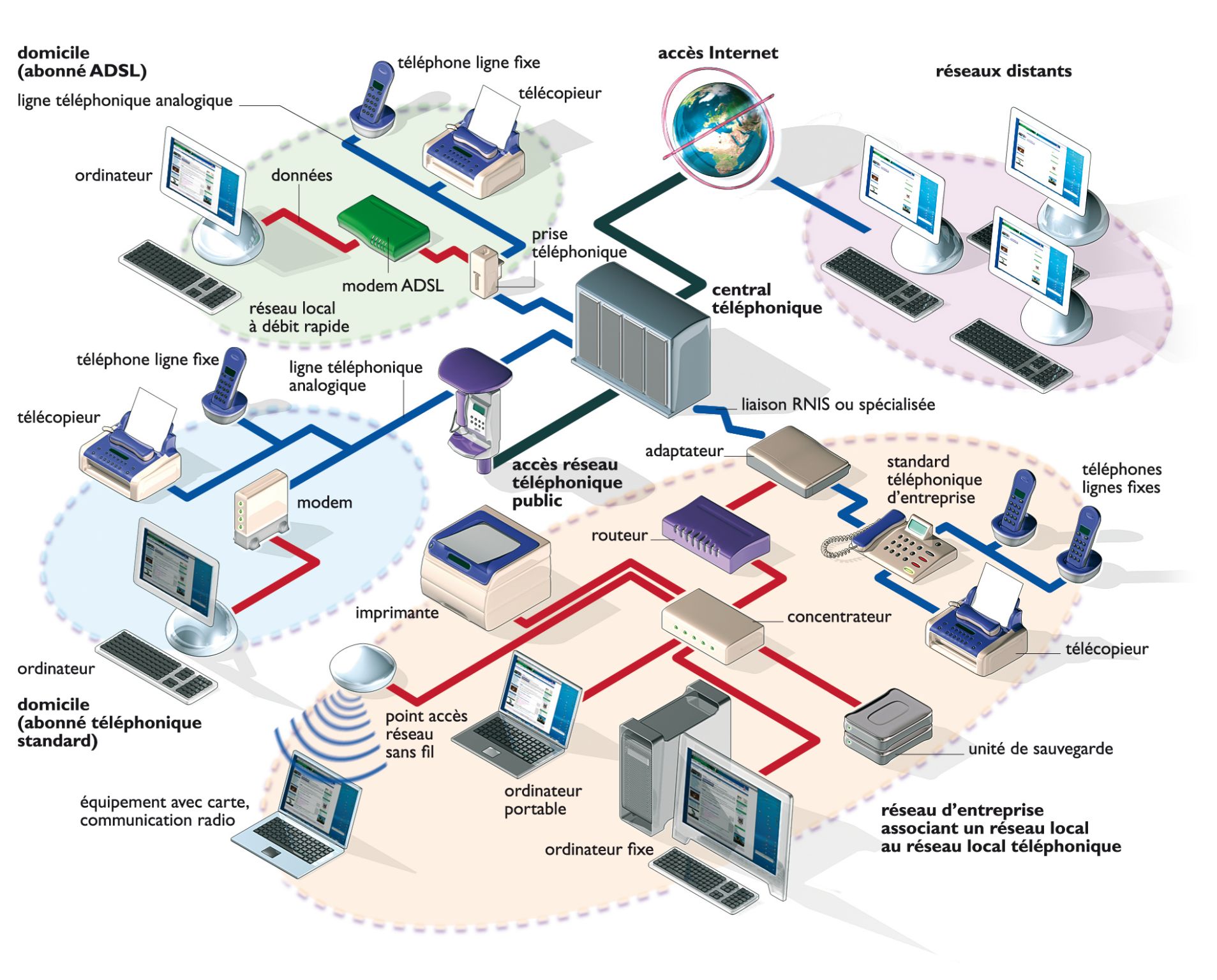

Mais une autre a déjà eu lieu au début des années 1990 : la création du réseau Internet. Désormais, le monde entier est connecté et l'informatique est présente dans tous les domaines de la vie professionnelle, sociale et privée sur des formats variés (ordinateurs portables, Smartphones, tablettes, etc.). Par ailleurs, l'informatique (intimement liée aux mathématiques) est devenue une discipline à part entière, avec ses propres champs d'études en perpétuel développement (programmation, algorithmique, cryptographie, analyse numérique, démonstration automatique, etc.) et une discipline auxiliaire incontournable pour tous les autres domaines scientifiques (physique, chimie, biologie, géologie, météorologie, etc.).